Alpha Notice: These docs cover the v1-alpha release. Content is incomplete and subject to change.For the latest stable version, see the current LangGraph Python or LangGraph JavaScript docs.

- 단기 메모리 추가: 에이전트의 상태의 일부로 단기 메모리를 추가하여 다중 턴 대화를 가능하게 합니다.

- 장기 메모리 추가: 세션 간에 사용자별 또는 애플리케이션 수준 데이터를 저장합니다.

단기 메모리 추가

단기 메모리(스레드 수준 지속성)를 사용하면 에이전트가 다중 턴 대화를 추적할 수 있습니다. 단기 메모리를 추가하는 방법은 다음과 같습니다:Copy

from langgraph.checkpoint.memory import InMemorySaver

from langgraph.graph import StateGraph

checkpointer = InMemorySaver()

builder = StateGraph(...)

graph = builder.compile(checkpointer=checkpointer)

graph.invoke(

{"messages": [{"role": "user", "content": "hi! i am Bob"}]},

{"configurable": {"thread_id": "1"}},

)

프로덕션 환경에서 사용하기

프로덕션 환경에서는 데이터베이스를 기반으로 하는 체크포인터를 사용하세요:Copy

from langgraph.checkpoint.postgres import PostgresSaver

DB_URI = "postgresql://postgres:postgres@localhost:5442/postgres?sslmode=disable"

with PostgresSaver.from_conn_string(DB_URI) as checkpointer:

builder = StateGraph(...)

graph = builder.compile(checkpointer=checkpointer)

예제: Postgres 체크포인터 사용하기

예제: Postgres 체크포인터 사용하기

Copy

pip install -U "psycopg[binary,pool]" langgraph langgraph-checkpoint-postgres

Postgres 체크포인터를 처음 사용할 때는

checkpointer.setup()을 호출해야 합니다- Sync

- Async

Copy

from langchain.chat_models import init_chat_model

from langgraph.graph import StateGraph, MessagesState, START

from langgraph.checkpoint.postgres import PostgresSaver

model = init_chat_model(model="anthropic:claude-3-5-haiku-latest")

DB_URI = "postgresql://postgres:postgres@localhost:5442/postgres?sslmode=disable"

with PostgresSaver.from_conn_string(DB_URI) as checkpointer:

# checkpointer.setup()

def call_model(state: MessagesState):

response = model.invoke(state["messages"])

return {"messages": response}

builder = StateGraph(MessagesState)

builder.add_node(call_model)

builder.add_edge(START, "call_model")

graph = builder.compile(checkpointer=checkpointer)

config = {

"configurable": {

"thread_id": "1"

}

}

for chunk in graph.stream(

{"messages": [{"role": "user", "content": "hi! I'm bob"}]},

config,

stream_mode="values"

):

chunk["messages"][-1].pretty_print()

for chunk in graph.stream(

{"messages": [{"role": "user", "content": "what's my name?"}]},

config,

stream_mode="values"

):

chunk["messages"][-1].pretty_print()

예제: [MongoDB](https://pypi.org/project/langgraph-checkpoint-mongodb/) 체크포인터 사용하기

예제: [MongoDB](https://pypi.org/project/langgraph-checkpoint-mongodb/) 체크포인터 사용하기

Copy

pip install -U pymongo langgraph langgraph-checkpoint-mongodb

설정

MongoDB 체크포인터를 사용하려면 MongoDB 클러스터가 필요합니다. 아직 클러스터가 없다면 이 가이드를 따라 클러스터를 생성하세요.

- Sync

- Async

Copy

from langchain.chat_models import init_chat_model

from langgraph.graph import StateGraph, MessagesState, START

from langgraph.checkpoint.mongodb import MongoDBSaver

model = init_chat_model(model="anthropic:claude-3-5-haiku-latest")

DB_URI = "localhost:27017"

with MongoDBSaver.from_conn_string(DB_URI) as checkpointer:

def call_model(state: MessagesState):

response = model.invoke(state["messages"])

return {"messages": response}

builder = StateGraph(MessagesState)

builder.add_node(call_model)

builder.add_edge(START, "call_model")

graph = builder.compile(checkpointer=checkpointer)

config = {

"configurable": {

"thread_id": "1"

}

}

for chunk in graph.stream(

{"messages": [{"role": "user", "content": "hi! I'm bob"}]},

config,

stream_mode="values"

):

chunk["messages"][-1].pretty_print()

for chunk in graph.stream(

{"messages": [{"role": "user", "content": "what's my name?"}]},

config,

stream_mode="values"

):

chunk["messages"][-1].pretty_print()

예제: [Redis](https://pypi.org/project/langgraph-checkpoint-redis/) 체크포인터 사용하기

예제: [Redis](https://pypi.org/project/langgraph-checkpoint-redis/) 체크포인터 사용하기

Copy

pip install -U langgraph langgraph-checkpoint-redis

Redis 체크포인터를 처음 사용할 때는

checkpointer.setup()을 호출해야 합니다- Sync

- Async

Copy

from langchain.chat_models import init_chat_model

from langgraph.graph import StateGraph, MessagesState, START

from langgraph.checkpoint.redis import RedisSaver

model = init_chat_model(model="anthropic:claude-3-5-haiku-latest")

DB_URI = "redis://localhost:6379"

with RedisSaver.from_conn_string(DB_URI) as checkpointer:

# checkpointer.setup()

def call_model(state: MessagesState):

response = model.invoke(state["messages"])

return {"messages": response}

builder = StateGraph(MessagesState)

builder.add_node(call_model)

builder.add_edge(START, "call_model")

graph = builder.compile(checkpointer=checkpointer)

config = {

"configurable": {

"thread_id": "1"

}

}

for chunk in graph.stream(

{"messages": [{"role": "user", "content": "hi! I'm bob"}]},

config,

stream_mode="values"

):

chunk["messages"][-1].pretty_print()

for chunk in graph.stream(

{"messages": [{"role": "user", "content": "what's my name?"}]},

config,

stream_mode="values"

):

chunk["messages"][-1].pretty_print()

서브그래프에서 사용하기

그래프에 서브그래프가 포함되어 있는 경우, 부모 그래프를 컴파일할 때만 체크포인터를 제공하면 됩니다. LangGraph가 자동으로 체크포인터를 자식 서브그래프에 전파합니다.Copy

from langgraph.graph import START, StateGraph

from langgraph.checkpoint.memory import InMemorySaver

from typing import TypedDict

class State(TypedDict):

foo: str

# 서브그래프

def subgraph_node_1(state: State):

return {"foo": state["foo"] + "bar"}

subgraph_builder = StateGraph(State)

subgraph_builder.add_node(subgraph_node_1)

subgraph_builder.add_edge(START, "subgraph_node_1")

subgraph = subgraph_builder.compile()

# 부모 그래프

builder = StateGraph(State)

builder.add_node("node_1", subgraph)

builder.add_edge(START, "node_1")

checkpointer = InMemorySaver()

graph = builder.compile(checkpointer=checkpointer)

Copy

subgraph_builder = StateGraph(...)

subgraph = subgraph_builder.compile(checkpointer=True)

장기 메모리 추가

장기 메모리를 사용하여 대화 간에 사용자별 또는 애플리케이션별 데이터를 저장하세요.Copy

from langgraph.store.memory import InMemoryStore

from langgraph.graph import StateGraph

store = InMemoryStore()

builder = StateGraph(...)

graph = builder.compile(store=store)

프로덕션 환경에서 사용하기

프로덕션 환경에서는 데이터베이스를 기반으로 하는 스토어를 사용하세요:Copy

from langgraph.store.postgres import PostgresStore

DB_URI = "postgresql://postgres:postgres@localhost:5442/postgres?sslmode=disable"

with PostgresStore.from_conn_string(DB_URI) as store:

builder = StateGraph(...)

graph = builder.compile(store=store)

예제: Postgres 스토어 사용하기

예제: Postgres 스토어 사용하기

Copy

pip install -U "psycopg[binary,pool]" langgraph langgraph-checkpoint-postgres

Postgres 스토어를 처음 사용할 때는

store.setup()을 호출해야 합니다- Sync

- Async

Copy

from langchain_core.runnables import RunnableConfig

from langchain.chat_models import init_chat_model

from langgraph.graph import StateGraph, MessagesState, START

from langgraph.checkpoint.postgres import PostgresSaver

from langgraph.store.postgres import PostgresStore

from langgraph.store.base import BaseStore

model = init_chat_model(model="anthropic:claude-3-5-haiku-latest")

DB_URI = "postgresql://postgres:postgres@localhost:5442/postgres?sslmode=disable"

with (

PostgresStore.from_conn_string(DB_URI) as store,

PostgresSaver.from_conn_string(DB_URI) as checkpointer,

):

# store.setup()

# checkpointer.setup()

def call_model(

state: MessagesState,

config: RunnableConfig,

*,

store: BaseStore,

):

user_id = config["configurable"]["user_id"]

namespace = ("memories", user_id)

memories = store.search(namespace, query=str(state["messages"][-1].content))

info = "\n".join([d.value["data"] for d in memories])

system_msg = f"You are a helpful assistant talking to the user. User info: {info}"

# 사용자가 모델에 기억하도록 요청하면 새로운 메모리를 저장합니다

last_message = state["messages"][-1]

if "remember" in last_message.content.lower():

memory = "User name is Bob"

store.put(namespace, str(uuid.uuid4()), {"data": memory})

response = model.invoke(

[{"role": "system", "content": system_msg}] + state["messages"]

)

return {"messages": response}

builder = StateGraph(MessagesState)

builder.add_node(call_model)

builder.add_edge(START, "call_model")

graph = builder.compile(

checkpointer=checkpointer,

store=store,

)

config = {

"configurable": {

"thread_id": "1",

"user_id": "1",

}

}

for chunk in graph.stream(

{"messages": [{"role": "user", "content": "Hi! Remember: my name is Bob"}]},

config,

stream_mode="values",

):

chunk["messages"][-1].pretty_print()

config = {

"configurable": {

"thread_id": "2",

"user_id": "1",

}

}

for chunk in graph.stream(

{"messages": [{"role": "user", "content": "what is my name?"}]},

config,

stream_mode="values",

):

chunk["messages"][-1].pretty_print()

예제: [Redis](https://pypi.org/project/langgraph-checkpoint-redis/) 스토어 사용하기

예제: [Redis](https://pypi.org/project/langgraph-checkpoint-redis/) 스토어 사용하기

Copy

pip install -U langgraph langgraph-checkpoint-redis

Redis 스토어를 처음 사용할 때는

store.setup()을 호출해야 합니다- Sync

- Async

Copy

from langchain_core.runnables import RunnableConfig

from langchain.chat_models import init_chat_model

from langgraph.graph import StateGraph, MessagesState, START

from langgraph.checkpoint.redis import RedisSaver

from langgraph.store.redis import RedisStore

from langgraph.store.base import BaseStore

model = init_chat_model(model="anthropic:claude-3-5-haiku-latest")

DB_URI = "redis://localhost:6379"

with (

RedisStore.from_conn_string(DB_URI) as store,

RedisSaver.from_conn_string(DB_URI) as checkpointer,

):

store.setup()

checkpointer.setup()

def call_model(

state: MessagesState,

config: RunnableConfig,

*,

store: BaseStore,

):

user_id = config["configurable"]["user_id"]

namespace = ("memories", user_id)

memories = store.search(namespace, query=str(state["messages"][-1].content))

info = "\n".join([d.value["data"] for d in memories])

system_msg = f"You are a helpful assistant talking to the user. User info: {info}"

# 사용자가 모델에 기억하도록 요청하면 새로운 메모리를 저장합니다

last_message = state["messages"][-1]

if "remember" in last_message.content.lower():

memory = "User name is Bob"

store.put(namespace, str(uuid.uuid4()), {"data": memory})

response = model.invoke(

[{"role": "system", "content": system_msg}] + state["messages"]

)

return {"messages": response}

builder = StateGraph(MessagesState)

builder.add_node(call_model)

builder.add_edge(START, "call_model")

graph = builder.compile(

checkpointer=checkpointer,

store=store,

)

config = {

"configurable": {

"thread_id": "1",

"user_id": "1",

}

}

for chunk in graph.stream(

{"messages": [{"role": "user", "content": "Hi! Remember: my name is Bob"}]},

config,

stream_mode="values",

):

chunk["messages"][-1].pretty_print()

config = {

"configurable": {

"thread_id": "2",

"user_id": "1",

}

}

for chunk in graph.stream(

{"messages": [{"role": "user", "content": "what is my name?"}]},

config,

stream_mode="values",

):

chunk["messages"][-1].pretty_print()

시맨틱 검색 사용하기

그래프의 메모리 스토어에서 시맨틱 검색을 활성화하여 그래프 에이전트가 스토어의 항목을 의미적 유사성으로 검색할 수 있도록 하세요.Copy

from langchain.embeddings import init_embeddings

from langgraph.store.memory import InMemoryStore

# 시맨틱 검색이 활성화된 스토어 생성

embeddings = init_embeddings("openai:text-embedding-3-small")

store = InMemoryStore(

index={

"embed": embeddings,

"dims": 1536,

}

)

store.put(("user_123", "memories"), "1", {"text": "I love pizza"})

store.put(("user_123", "memories"), "2", {"text": "I am a plumber"})

items = store.search(

("user_123", "memories"), query="I'm hungry", limit=1

)

시맨틱 검색을 사용한 장기 메모리

시맨틱 검색을 사용한 장기 메모리

Copy

from langchain.embeddings import init_embeddings

from langchain.chat_models import init_chat_model

from langgraph.store.base import BaseStore

from langgraph.store.memory import InMemoryStore

from langgraph.graph import START, MessagesState, StateGraph

llm = init_chat_model("openai:gpt-4o-mini")

# 시맨틱 검색이 활성화된 스토어 생성

embeddings = init_embeddings("openai:text-embedding-3-small")

store = InMemoryStore(

index={

"embed": embeddings,

"dims": 1536,

}

)

store.put(("user_123", "memories"), "1", {"text": "I love pizza"})

store.put(("user_123", "memories"), "2", {"text": "I am a plumber"})

def chat(state, *, store: BaseStore):

# 사용자의 마지막 메시지를 기반으로 검색

items = store.search(

("user_123", "memories"), query=state["messages"][-1].content, limit=2

)

memories = "\n".join(item.value["text"] for item in items)

memories = f"## Memories of user\n{memories}" if memories else ""

response = llm.invoke(

[

{"role": "system", "content": f"You are a helpful assistant.\n{memories}"},

*state["messages"],

]

)

return {"messages": [response]}

builder = StateGraph(MessagesState)

builder.add_node(chat)

builder.add_edge(START, "chat")

graph = builder.compile(store=store)

for message, metadata in graph.stream(

input={"messages": [{"role": "user", "content": "I'm hungry"}]},

stream_mode="messages",

):

print(message.content, end="")

단기 메모리 관리

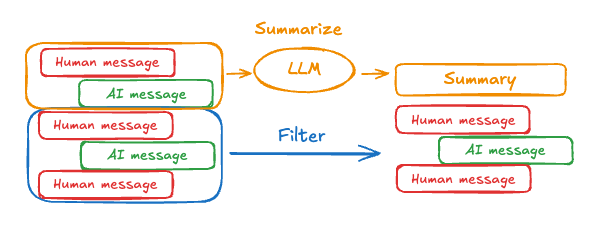

단기 메모리가 활성화되면 긴 대화가 LLM의 컨텍스트 윈도우를 초과할 수 있습니다. 일반적인 해결 방법은 다음과 같습니다:- 메시지 잘라내기: 처음 또는 마지막 N개의 메시지 제거하기 (LLM 호출 전)

- 메시지 삭제하기: LangGraph 상태에서 메시지 영구 삭제하기

- 메시지 요약하기: 히스토리의 초기 메시지들을 요약하여 요약본으로 대체하기

- 체크포인트 관리하기: 메시지 히스토리 저장 및 검색하기

- 사용자 정의 전략 (예: 메시지 필터링 등)

메시지 잘라내기

대부분의 LLM에는 지원되는 최대 컨텍스트 윈도우(토큰 단위)가 있습니다. 메시지를 자를 시점을 결정하는 한 가지 방법은 메시지 히스토리의 토큰 수를 세어 해당 제한에 근접할 때마다 잘라내는 것입니다. LangChain을 사용하는 경우, trim messages 유틸리티를 사용하여 목록에서 유지할 토큰 수와 경계를 처리하기 위한strategy(예: 마지막 maxTokens 유지)를 지정할 수 있습니다.

메시지 히스토리를 자르려면 trim_messages 함수를 사용하세요:

Copy

from langchain_core.messages.utils import (

trim_messages,

count_tokens_approximately

)

def call_model(state: MessagesState):

messages = trim_messages(

state["messages"],

strategy="last",

token_counter=count_tokens_approximately,

max_tokens=128,

start_on="human",

end_on=("human", "tool"),

)

response = model.invoke(messages)

return {"messages": [response]}

builder = StateGraph(MessagesState)

builder.add_node(call_model)

...

전체 예제: 메시지 잘라내기

전체 예제: 메시지 잘라내기

Copy

from langchain_core.messages.utils import (

trim_messages,

count_tokens_approximately

)

from langchain.chat_models import init_chat_model

from langgraph.graph import StateGraph, START, MessagesState

model = init_chat_model("anthropic:claude-3-7-sonnet-latest")

summarization_model = model.bind(max_tokens=128)

def call_model(state: MessagesState):

messages = trim_messages(

state["messages"],

strategy="last",

token_counter=count_tokens_approximately,

max_tokens=128,

start_on="human",

end_on=("human", "tool"),

)

response = model.invoke(messages)

return {"messages": [response]}

checkpointer = InMemorySaver()

builder = StateGraph(MessagesState)

builder.add_node(call_model)

builder.add_edge(START, "call_model")

graph = builder.compile(checkpointer=checkpointer)

config = {"configurable": {"thread_id": "1"}}

graph.invoke({"messages": "hi, my name is bob"}, config)

graph.invoke({"messages": "write a short poem about cats"}, config)

graph.invoke({"messages": "now do the same but for dogs"}, config)

final_response = graph.invoke({"messages": "what's my name?"}, config)

final_response["messages"][-1].pretty_print()

Copy

================================== Ai Message ==================================

Your name is Bob, as you mentioned when you first introduced yourself.

메시지 삭제하기

그래프 상태에서 메시지를 삭제하여 메시지 히스토리를 관리할 수 있습니다. 특정 메시지를 제거하거나 전체 메시지 히스토리를 지우고 싶을 때 유용합니다. 그래프 상태에서 메시지를 삭제하려면RemoveMessage를 사용할 수 있습니다. RemoveMessage가 작동하려면 MessagesState와 같이 add_messages 리듀서가 있는 상태 키를 사용해야 합니다.

특정 메시지를 제거하려면:

Copy

from langchain.messages import RemoveMessage

def delete_messages(state):

messages = state["messages"]

if len(messages) > 2:

# 가장 초기의 두 메시지 제거

return {"messages": [RemoveMessage(id=m.id) for m in messages[:2]]}

Copy

from langgraph.graph.message import REMOVE_ALL_MESSAGES

def delete_messages(state):

return {"messages": [RemoveMessage(id=REMOVE_ALL_MESSAGES)]}

메시지를 삭제할 때는 결과로 나오는 메시지 히스토리가 유효한지 반드시 확인하세요. 사용 중인 LLM 제공자의 제한 사항을 확인하세요. 예를 들어:

- 일부 제공자는 메시지 히스토리가

user메시지로 시작할 것을 기대합니다 - 대부분의 제공자는 도구 호출이 있는

assistant메시지 다음에 해당하는tool결과 메시지가 와야 합니다.

전체 예제: 메시지 삭제하기

전체 예제: 메시지 삭제하기

Copy

from langchain.messages import RemoveMessage

def delete_messages(state):

messages = state["messages"]

if len(messages) > 2:

# 가장 초기의 두 메시지 제거

return {"messages": [RemoveMessage(id=m.id) for m in messages[:2]]}

def call_model(state: MessagesState):

response = model.invoke(state["messages"])

return {"messages": response}

builder = StateGraph(MessagesState)

builder.add_sequence([call_model, delete_messages])

builder.add_edge(START, "call_model")

checkpointer = InMemorySaver()

app = builder.compile(checkpointer=checkpointer)

for event in app.stream(

{"messages": [{"role": "user", "content": "hi! I'm bob"}]},

config,

stream_mode="values"

):

print([(message.type, message.content) for message in event["messages"]])

for event in app.stream(

{"messages": [{"role": "user", "content": "what's my name?"}]},

config,

stream_mode="values"

):

print([(message.type, message.content) for message in event["messages"]])

Copy

[('human', "hi! I'm bob")]

[('human', "hi! I'm bob"), ('ai', 'Hi Bob! How are you doing today? Is there anything I can help you with?')]

[('human', "hi! I'm bob"), ('ai', 'Hi Bob! How are you doing today? Is there anything I can help you with?'), ('human', "what's my name?")]

[('human', "hi! I'm bob"), ('ai', 'Hi Bob! How are you doing today? Is there anything I can help you with?'), ('human', "what's my name?"), ('ai', 'Your name is Bob.')]

[('human', "what's my name?"), ('ai', 'Your name is Bob.')]

메시지 요약하기

위에 표시된 것처럼 메시지를 자르거나 제거하는 것의 문제점은 메시지 큐를 정리함으로써 정보를 잃을 수 있다는 것입니다. 이 때문에 일부 애플리케이션은 채팅 모델을 사용하여 메시지 히스토리를 요약하는 보다 정교한 접근 방식의 이점을 얻습니다.

MessagesState를 확장하여 summary 키를 포함할 수 있습니다:

Copy

from langgraph.graph import MessagesState

class State(MessagesState):

summary: str

summarize_conversation 노드는 messages 상태 키에 일정 수의 메시지가 누적된 후에 호출될 수 있습니다.

Copy

def summarize_conversation(state: State):

# 먼저, 기존 요약을 가져옵니다

summary = state.get("summary", "")

# 요약 프롬프트를 생성합니다

if summary:

# 요약이 이미 존재합니다

summary_message = (

f"This is a summary of the conversation to date: {summary}\n\n"

"Extend the summary by taking into account the new messages above:"

)

else:

summary_message = "Create a summary of the conversation above:"

# 히스토리에 프롬프트를 추가합니다

messages = state["messages"] + [HumanMessage(content=summary_message)]

response = model.invoke(messages)

# 가장 최근 2개를 제외한 모든 메시지를 삭제합니다

delete_messages = [RemoveMessage(id=m.id) for m in state["messages"][:-2]]

return {"summary": response.content, "messages": delete_messages}

전체 예제: 메시지 요약하기

전체 예제: 메시지 요약하기

Copy

from typing import Any, TypedDict

from langchain.chat_models import init_chat_model

from langchain.messages import AnyMessage

from langchain_core.messages.utils import count_tokens_approximately

from langgraph.graph import StateGraph, START, MessagesState

from langgraph.checkpoint.memory import InMemorySaver

from langmem.short_term import SummarizationNode, RunningSummary

model = init_chat_model("anthropic:claude-3-7-sonnet-latest")

summarization_model = model.bind(max_tokens=128)

class State(MessagesState):

context: dict[str, RunningSummary] # (1)!

class LLMInputState(TypedDict): # (2)!

summarized_messages: list[AnyMessage]

context: dict[str, RunningSummary]

summarization_node = SummarizationNode(

token_counter=count_tokens_approximately,

model=summarization_model,

max_tokens=256,

max_tokens_before_summary=256,

max_summary_tokens=128,

)

def call_model(state: LLMInputState): # (3)!

response = model.invoke(state["summarized_messages"])

return {"messages": [response]}

checkpointer = InMemorySaver()

builder = StateGraph(State)

builder.add_node(call_model)

builder.add_node("summarize", summarization_node)

builder.add_edge(START, "summarize")

builder.add_edge("summarize", "call_model")

graph = builder.compile(checkpointer=checkpointer)

# 그래프 호출

config = {"configurable": {"thread_id": "1"}}

graph.invoke({"messages": "hi, my name is bob"}, config)

graph.invoke({"messages": "write a short poem about cats"}, config)

graph.invoke({"messages": "now do the same but for dogs"}, config)

final_response = graph.invoke({"messages": "what's my name?"}, config)

final_response["messages"][-1].pretty_print()

print("\nSummary:", final_response["context"]["running_summary"].summary)

- 실행 중인 요약을

context필드에 추적합니다

SummarizationNode에서 예상됨).-

call_model노드에 대한 입력을 필터링하는 데만 사용될 비공개 상태를 정의합니다 - 여기서 비공개 입력 상태를 전달하여 요약 노드에서 반환된 메시지를 분리합니다

Copy

================================== Ai Message ==================================

From our conversation, I can see that you introduced yourself as Bob. That's the name you shared with me when we began talking.

Summary: In this conversation, I was introduced to Bob, who then asked me to write a poem about cats. I composed a poem titled "The Mystery of Cats" that captured cats' graceful movements, independent nature, and their special relationship with humans. Bob then requested a similar poem about dogs, so I wrote "The Joy of Dogs," which highlighted dogs' loyalty, enthusiasm, and loving companionship. Both poems were written in a similar style but emphasized the distinct characteristics that make each pet special.

체크포인트 관리하기

체크포인터가 저장한 정보를 보고 삭제할 수 있습니다.스레드 상태 보기

- Graph/Functional API

- Checkpointer API

Copy

config = {

"configurable": {

"thread_id": "1",

# 선택적으로 특정 체크포인트의 ID를 제공합니다,

# 그렇지 않으면 최신 체크포인트가 표시됩니다

# "checkpoint_id": "1f029ca3-1f5b-6704-8004-820c16b69a5a"

}

}

graph.get_state(config)

Copy

StateSnapshot(

values={'messages': [HumanMessage(content="hi! I'm bob"), AIMessage(content='Hi Bob! How are you doing today?), HumanMessage(content="what's my name?"), AIMessage(content='Your name is Bob.')]}, next=(),

config={'configurable': {'thread_id': '1', 'checkpoint_ns': '', 'checkpoint_id': '1f029ca3-1f5b-6704-8004-820c16b69a5a'}},

metadata={

'source': 'loop',

'writes': {'call_model': {'messages': AIMessage(content='Your name is Bob.')}},

'step': 4,

'parents': {},

'thread_id': '1'

},

created_at='2025-05-05T16:01:24.680462+00:00',

parent_config={'configurable': {'thread_id': '1', 'checkpoint_ns': '', 'checkpoint_id': '1f029ca3-1790-6b0a-8003-baf965b6a38f'}},

tasks=(),

interrupts=()

)

스레드의 히스토리 보기

- Graph/Functional API

- Checkpointer API

Copy

config = {

"configurable": {

"thread_id": "1"

}

}

list(graph.get_state_history(config))

Copy

[

StateSnapshot(

values={'messages': [HumanMessage(content="hi! I'm bob"), AIMessage(content='Hi Bob! How are you doing today? Is there anything I can help you with?'), HumanMessage(content="what's my name?"), AIMessage(content='Your name is Bob.')]},

next=(),

config={'configurable': {'thread_id': '1', 'checkpoint_ns': '', 'checkpoint_id': '1f029ca3-1f5b-6704-8004-820c16b69a5a'}},

metadata={'source': 'loop', 'writes': {'call_model': {'messages': AIMessage(content='Your name is Bob.')}}, 'step': 4, 'parents': {}, 'thread_id': '1'},

created_at='2025-05-05T16:01:24.680462+00:00',

parent_config={'configurable': {'thread_id': '1', 'checkpoint_ns': '', 'checkpoint_id': '1f029ca3-1790-6b0a-8003-baf965b6a38f'}},

tasks=(),

interrupts=()

),

StateSnapshot(

values={'messages': [HumanMessage(content="hi! I'm bob"), AIMessage(content='Hi Bob! How are you doing today? Is there anything I can help you with?'), HumanMessage(content="what's my name?")]},

next=('call_model',),

config={'configurable': {'thread_id': '1', 'checkpoint_ns': '', 'checkpoint_id': '1f029ca3-1790-6b0a-8003-baf965b6a38f'}},

metadata={'source': 'loop', 'writes': None, 'step': 3, 'parents': {}, 'thread_id': '1'},

created_at='2025-05-05T16:01:23.863421+00:00',

parent_config={...}

tasks=(PregelTask(id='8ab4155e-6b15-b885-9ce5-bed69a2c305c', name='call_model', path=('__pregel_pull', 'call_model'), error=None, interrupts=(), state=None, result={'messages': AIMessage(content='Your name is Bob.')}),),

interrupts=()

),

StateSnapshot(

values={'messages': [HumanMessage(content="hi! I'm bob"), AIMessage(content='Hi Bob! How are you doing today? Is there anything I can help you with?')]},

next=('__start__',),

config={...},

metadata={'source': 'input', 'writes': {'__start__': {'messages': [{'role': 'user', 'content': "what's my name?"}]}}, 'step': 2, 'parents': {}, 'thread_id': '1'},

created_at='2025-05-05T16:01:23.863173+00:00',

parent_config={...}

tasks=(PregelTask(id='24ba39d6-6db1-4c9b-f4c5-682aeaf38dcd', name='__start__', path=('__pregel_pull', '__start__'), error=None, interrupts=(), state=None, result={'messages': [{'role': 'user', 'content': "what's my name?"}]}),),

interrupts=()

),

StateSnapshot(

values={'messages': [HumanMessage(content="hi! I'm bob"), AIMessage(content='Hi Bob! How are you doing today? Is there anything I can help you with?')]},

next=(),

config={...},

metadata={'source': 'loop', 'writes': {'call_model': {'messages': AIMessage(content='Hi Bob! How are you doing today? Is there anything I can help you with?')}}, 'step': 1, 'parents': {}, 'thread_id': '1'},

created_at='2025-05-05T16:01:23.862295+00:00',

parent_config={...}

tasks=(),

interrupts=()

),

StateSnapshot(

values={'messages': [HumanMessage(content="hi! I'm bob")]},

next=('call_model',),

config={...},

metadata={'source': 'loop', 'writes': None, 'step': 0, 'parents': {}, 'thread_id': '1'},

created_at='2025-05-05T16:01:22.278960+00:00',

parent_config={...}

tasks=(PregelTask(id='8cbd75e0-3720-b056-04f7-71ac805140a0', name='call_model', path=('__pregel_pull', 'call_model'), error=None, interrupts=(), state=None, result={'messages': AIMessage(content='Hi Bob! How are you doing today? Is there anything I can help you with?')}),),

interrupts=()

),

StateSnapshot(

values={'messages': []},

next=('__start__',),

config={'configurable': {'thread_id': '1', 'checkpoint_ns': '', 'checkpoint_id': '1f029ca3-0870-6ce2-bfff-1f3f14c3e565'}},

metadata={'source': 'input', 'writes': {'__start__': {'messages': [{'role': 'user', 'content': "hi! I'm bob"}]}}, 'step': -1, 'parents': {}, 'thread_id': '1'},

created_at='2025-05-05T16:01:22.277497+00:00',

parent_config=None,

tasks=(PregelTask(id='d458367b-8265-812c-18e2-33001d199ce6', name='__start__', path=('__pregel_pull', '__start__'), error=None, interrupts=(), state=None, result={'messages': [{'role': 'user', 'content': "hi! I'm bob"}]}),),

interrupts=()

)

]

스레드의 모든 체크포인트 삭제하기

Copy

thread_id = "1"

checkpointer.delete_thread(thread_id)